Walka z dezinformacją trwa. YouTube to jedna z najważniejszych platform na świecie, na której wiadomości błyskawicznie zmieniają się w viral – czy są prawdziwe, czy też nie. Najlepszym sposobem na odróżnienie prawdy od fałszu jest nie sztuczna inteligencja, a użytkownicy serwisu.

Od dłuższego czasu na Twitterze (X) istnieje możliwość dodania notki, która wyjaśnia, czy informacja podana we wpisie jest prawdziwa, czy nie. W ten sposób użytkownicy będący członkiem tego programu mogą na portalu Elona Muska dodać do wpisów innych autorów tekst wyjaśniający spotkane w nim nadużycie. Jest to potrzebne, by napisać na przykład, że wrzucone wideo, mimo iż jest opisane jako film pokazujący działania podczas wojny w Ukrainie, tak naprawdę pochodzi z 2018 roku z zupełnie innego miejsca świata (tego typu zakłamań było szczególnie dużo).

To oddolny sposób na walkę z farmami trolli, które wykorzystują to, że użytkownicy social media bardzo rzadko poświęcają chwilę na weryfikację tego co widzą, a jeżeli ktoś to opisuje w osobnych wpisach to, zwykle nie trafiają one do ogółu. Odpowiednio oznaczony główny wpis, który jest podawany dalej, ma zupełnie inną moc.

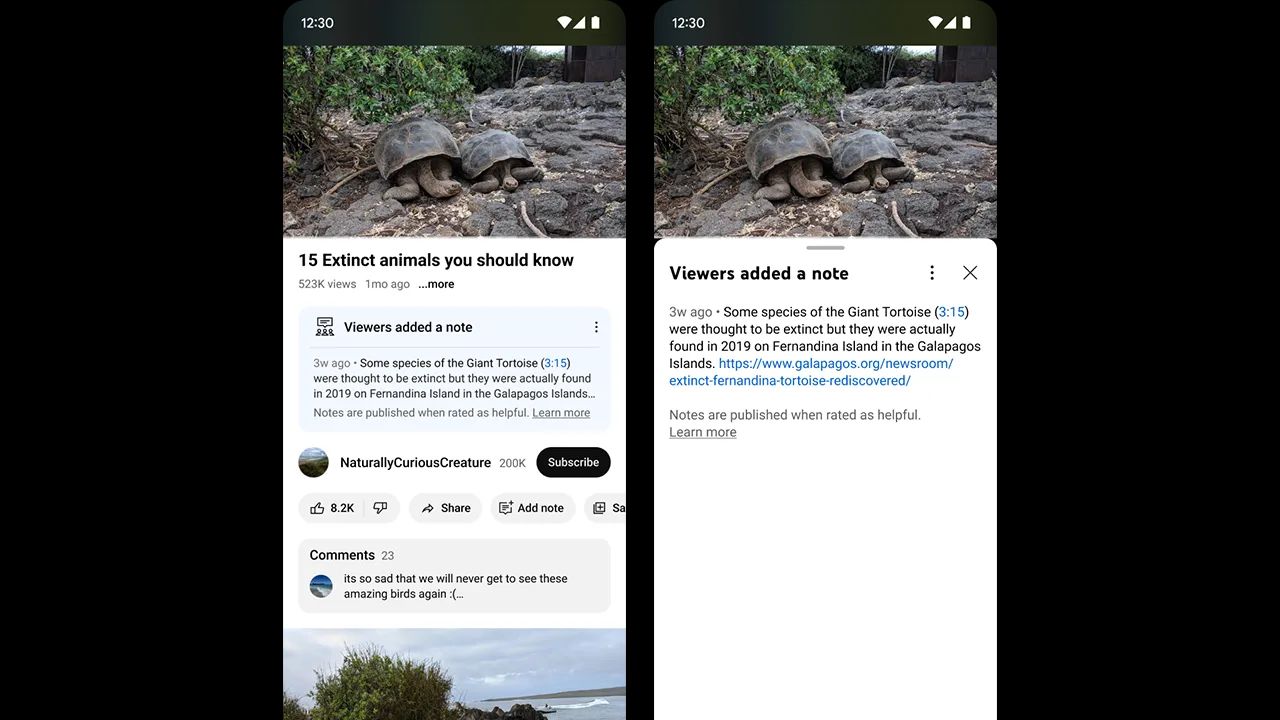

Od lipca podobne rozwiązanie jest testowane przez YouTube i od kilku dni funkcja zaczyna docierać do kolejnych użytkowników (takie zmiany zwykle nie są masowe). Dzięki niej można wybrać fragment wideo, w którym autor mówi nieprawdę albo się myli i oznaczyć ją w widoczny dla wszystkich sposób. Do tej pory, gdy używano do tego systemu komentarzy, niewiele to dawało, a takie noty społeczności/community notes będą na stałe przypięte w widocznym miejscu i łatwe do przeglądania.

Czy pozwoli to wygrać z dezinformacją i fanami teorii spiskowych? Na pewno będzie to trudne, ale poczyniono krok w dobrą stronę. Ciekawe kiedy to samo zacznie robić Meta…